ボードゲームは、膨大な探索空間であっても、思った通りに手を打てる環境です。これは例えば、自動運転の場面とは異なります。探索空間はさらに膨大となり、道路の摩擦や視界の閉塞などの要因で、思った通りに運転をコントロールできません。加えて、これまでの強化学習が扱っていた、状態と行動の組み合わせのテーブル表現を超えて、連続的なデータの複雑な関係を扱う必要もあります。

このように、人の社会にAIが入ってくる状況では、人の特性を考慮しながら、安全と効率を担保した技術でなければなりません。

当研究室では、強化学習を軸として、自動運転や防災、省エネ管理など、人の社会で使えるAIシステムの設計を行なっています。私自身の学術的関心は、様々な関心を持った主体が集団になった際、いわゆる「文殊の知恵」と呼ばれる集団知を基に、課題の最適解を見出して実行するプロセスにあります。

一般社会でも、「鶴の一声」のようなップダウン型の指令ではなく、共同体の個々のメンバーが、お互いの利害関係の衝突を解消しながら、全体の最適解を探ることが理想であると言われることがあります。この理想は、人工知能において情報の統合を担うマルチエージェントシステムの理想型とも重なります。 このため当研究室では、行動の主体となるエージェントが互いに協調しながら最適解を見出すプロセスを、強化学習・逆強化学習・模倣学習といった機械学習の手法を使って様々なシステム設計に活かそうとしています。

一般社会でも、「鶴の一声」のようなップダウン型の指令ではなく、共同体の個々のメンバーが、お互いの利害関係の衝突を解消しながら、全体の最適解を探ることが理想であると言われることがあります。この理想は、人工知能において情報の統合を担うマルチエージェントシステムの理想型とも重なります。 このため当研究室では、行動の主体となるエージェントが互いに協調しながら最適解を見出すプロセスを、強化学習・逆強化学習・模倣学習といった機械学習の手法を使って様々なシステム設計に活かそうとしています。

特に、逆強化学習は、強化学習において難しい課題となる「報酬」の設計を機械的に推定することができ、運転の熟練者や、ハチなどの生物の行動履歴から行動原理を解明することに役立ちます。逆強化学習で明らかになった行動原理を元に、改めて強化学習の手法を用いることで、未知の環境下にあっても最適な方策を導く自律システム制御の設計につながります。

これまで、こうした機械学習の手法を使って、自動運転や自律型無人潜水機に関する企業と共同研究を行ってきました。今後は、こうした知見をドローンに活かす研究につなげていきます。水・陸・空の幅広い空間で、ロボットと人が共存し、共進化するためのプラットフォームの構築を目指します。

Reference

- 中田勇介,荒井幸代:複数環境におけるエキスパート軌跡を用いたベイジアン逆強化学習, 人工知能学会論文誌,Vol. 35, No.1, p. G-J73_1-10 (2020.1.1),DOI:https://doi.org/10.1527/tjsai.G-J73

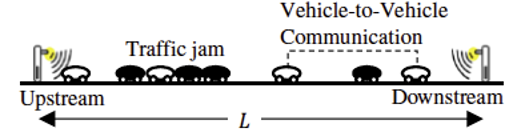

- 石川翔太,荒井幸代 : 渋滞低減に向けた路車間・車車間協調を実現する自動運転方策の学習法,人工知能学会論文誌, Vol34, No.1, p.D-155_1-9 (2019.1), DOI :https://doi.org/10.1527/tjsai.D-I55

- Daiko Kishikawa and Sachiyo Arai, Comfortable Driving by Using Deep Inverse Reinforcement Learning, The 4th IEEE International Conference on Agents (ICA 2019), 18-21, October 2019 at Jinan, China, (2019).

Profile

荒井幸代(あらい・さちよ)

ソニー株式会社を経て、東京工業大学大学院総合理工学研究科にて博士(工学)を取得。カルフォルニア大学バークレー校、カーネギー・メロン大学、京都大学、スタンフォード大学、国立情報学研究所を経て、現在、千葉大学大学院工学研究院 教授。自律分散システム、マルチエージェント系の機械学習を専門とする。